Zašto je NVIDIA postala toliko važna za AI?

NVIDIA danas u industriji umjetne inteligencije nije samo proizvođač grafičkih kartica. Ona je istodobno platforma, infrastrukturni standard i ključni dobavljač računalne snage na kojoj se trenira i pokreće većina suvremenih AI sietema. Taj položaj nije rezultat jednoga izuma ili jednoga tržišnog vala, nego dugotrajnog tehnološkog i strateškog razvoja koji je započeo puno prije aktualnog AI “booma”.

Ovaj članak objašnjava kako je NVIDIA došla u tu poziciju, zašto je njezina uloga danas toliko dominantna te gdje se nalaze realni rizici u slučaju pucanja AI balona.

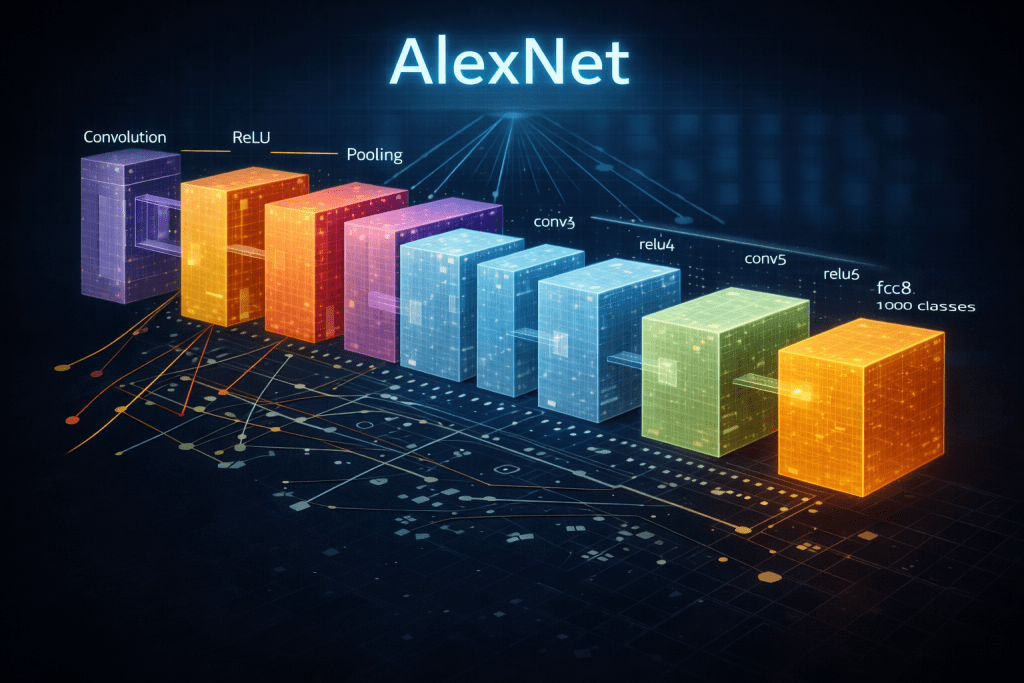

Grafički procesori (GPU-i) izvorno su razvijeni za obradu slike i videa. No već u ranim fazama razvoja bilo je jasno da je njihova prava snaga u masivnom paralelizmu: tisuće jednostavnijih jezgri koje istovremeno izvršavaju iste operacije nad velikim količinama podataka.

Takva arhitektura savršeno odgovara matematici koja stoji iza neuronskih mreža: matrice, vektori i linearne transformacije. Drugim riječima, AI problemi prirodno “leže” na GPU arhitekturi, i to mnogo bolje nego na klasičnim procesorima.

Presudan trenutak nije bio hardverski, nego softverski.

S razvojem CUDA platforme NVIDIA je omogućila programerima da GPU koriste kao opći računalni akcelerator. Time je uklonjena najveća prepreka: potreba za specijaliziranim znanjem grafičkog programiranja. CUDA nije bila samo alat, nego dugoročna strategija. Kako su godine prolazile, sve više znanstvenog, istraživačkog i industrijskog softvera pisano je upravo za CUDA okruženje. To je stvorilo snažan efekt zaključavanja, a kada su se pojavile alternativne hardverske opcije, trošak prelaska bio je velik. U tehnološkom smislu, NVIDIA je već tada prestala prodavati “čipove” i počela graditi platformu.

Razvoj CUDA-e započeo je sredinom 2000-ih, a službeni javni početak smatra se 2006.–2007.

Preciznije:

-

2006. – NVIDIA interno predstavlja koncept CUDA (Compute Unified Device Architecture) kao novi način korištenja GPU-a za opće računanje, izvan grafike.

-

2007. – izlazi prva javna verzija CUDA platforme, zajedno s razvojnim alatima i dokumentacijom dostupnom programerima.

To je bio ključni strateški trenutak, prvi put je GPU sustavno predstavljen kao paralelni koprocesor za opće namjene, a ne samo kao grafička komponenta. Upravo taj potez omogućio je kasniji procvat GPU-ubrzanog znanstvenog računarstva, a vremenom i eksploziju dubokog učenja odnosno modernog AI-ja. Pravi proboj dubokog učenja dogodio se 2012-e godine, kada su neuronske mreže trenirane na GPU-ima uvjerljivo nadmašile dotadašnje metode u računalnom vidu. Ključna poruka tog uspjeha bila je jednostavna: napredak AI-ja više ne ovisi samo o algoritmima, nego i o računalnoj infrastrukturi. Od tog trenutka AI prestaje biti isključivo akademski interes i postaje industrijska disciplina. Tko kontrolira računalnu snagu, kontrolira tempo napretka.

Kako su modeli postajali složeniji, pojavio se novi problem: reproducibilnost i skaliranje. NVIDIA je odgovorila razvojem optimiziranih biblioteka za duboko učenje, čime je standardizirala osnovne operacije i dodatno učvrstila svoju poziciju u softverskom sloju.

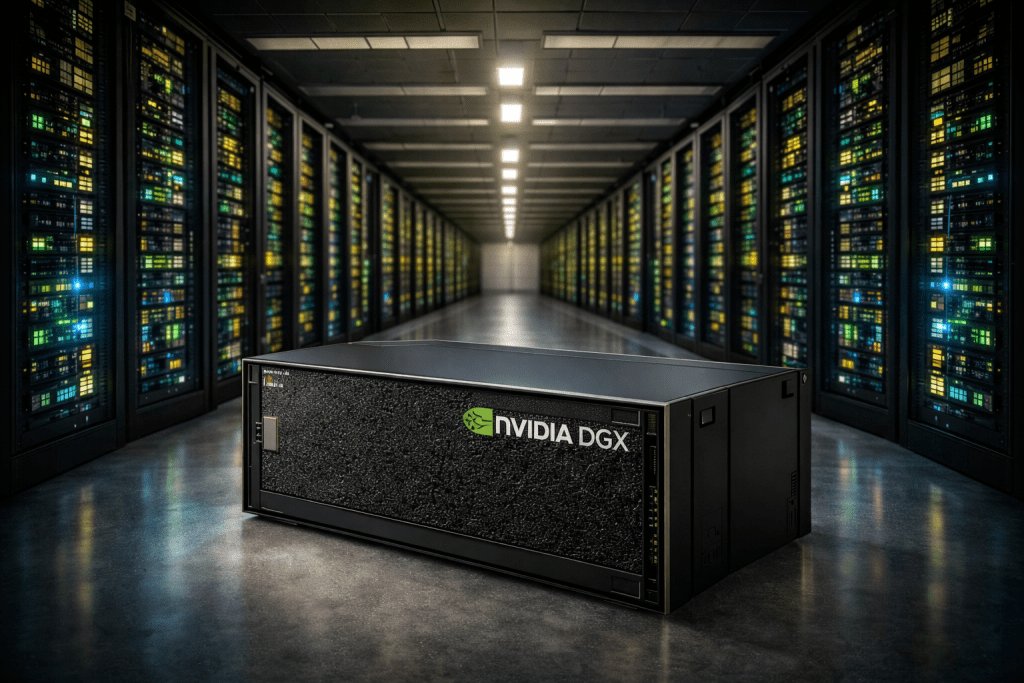

Sljedeći logičan korak bio je ulazak u gotova rješenja. Umjesto da kupci sami sastavljaju sustave, NVIDIA je počela nuditi kompletne AI sustave dizajnirane upravo za treniranje i izvođenje neuronskih mreža. Time se pomaknula još bliže ulozi infrastrukturnog dobavljača.

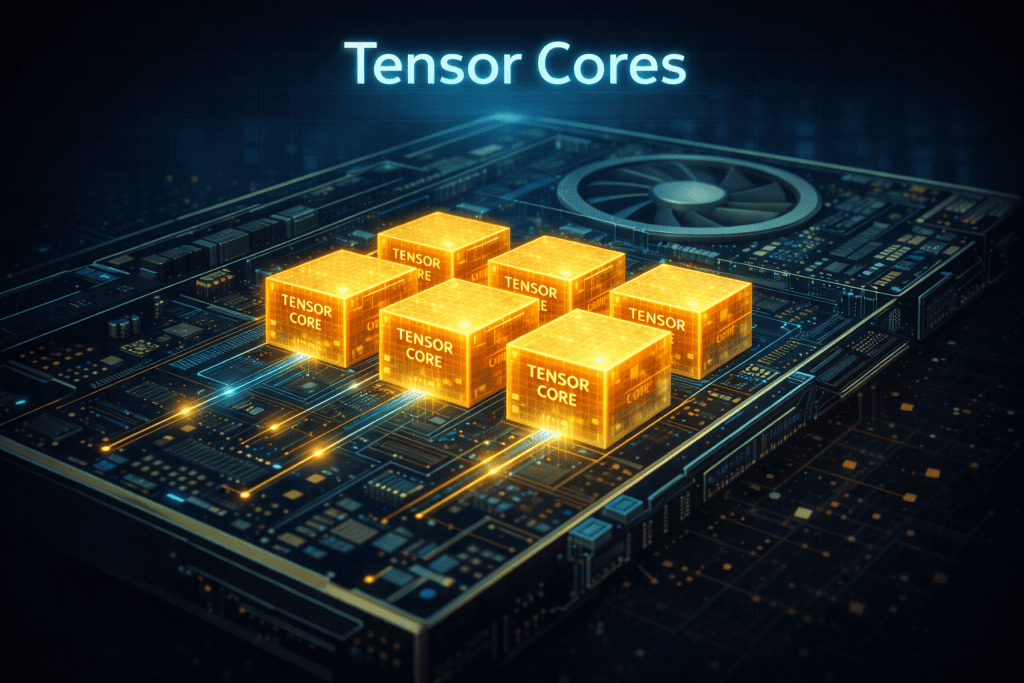

Uvođenjem specijaliziranih jedinica za operacije tipične za duboko učenje, NVIDIA je jasno signalizirala smjer razvoja: GPU više nije univerzalni grafički ili znanstveni akcelerator, nego ciljano optimiziran AI procesor.

Svaka nova generacija hardvera dodatno je povećavala performanse u AI zadacima, ali još važnije – produbljivala ovisnost softverskog ekosustava o NVIDIA arhitekturi.

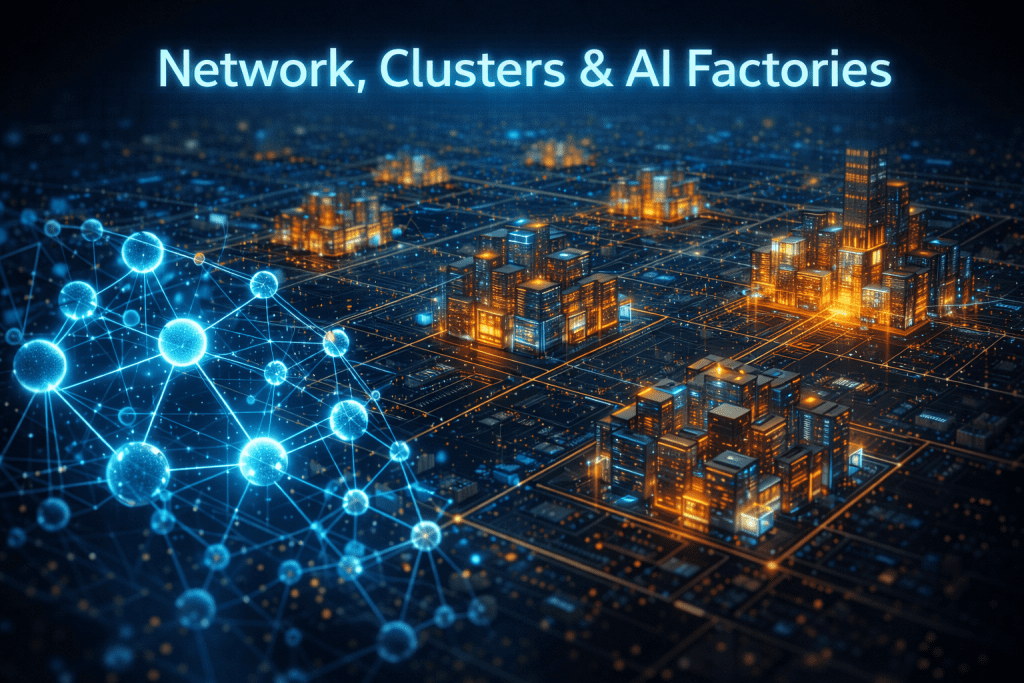

Moderni AI modeli ne treniraju se na jednom procesoru, nego na hiljadama njih, povezanih u ogromne klastere. U tom kontekstu, brzina komunikacije između čipova postaje jednako važna kao i snaga samih procesora.

Preuzimanjem mrežnih tehnologija i integracijom u vlastita rješenja, NVIDIA je osigurala kontrolu nad cijelim lancem performansi: od izračuna, preko memorije, do mrežnog prometa. To je omogućilo stvaranje onoga što se često naziva “AI fabrikama”, računskim centrima optimiziranim isključivo za umjetnu inteligenciju.

Danas NVIDIA ne prodaje samo čipove, nego referentnu arhitekturu za AI računske centre. Kada organizacija jednom izgradi sustave, procese i softver oko te arhitekture, promjena dobavljača postaje skupa i rizična.

To je ključno objašnjenje zašto je NVIDIA postala toliko važna, ona je postala standard, a standardi u tehnologiji imaju iznimno dug životni vijek.

Realna analiza budućeg razvoja NVIDIA-e i AI tržišta

Ulazak umjetne inteligencije u fazu masovne primjene mijenja prirodu tržišta na kojem NVIDIA djeluje. Dosadašnja utrka u treniranju sve većih modela postupno ustupa mjesto pitanju isplativosti; koliko košta izvođenje modela u stvarnim aplikacijama, kolika je potrošnja energije, koliki je stvarni povrat na uloženi kapital. U sljedećih nekoliko godina, upravo će ta pitanja odrediti brzinu i smjer rasta NVIDIA-e.

Najvažnija strukturna promjena jest pomak fokusa s treniranja na inferenciju. Treniranje velikih modela ostat će koncentrirano kod malog broja globalnih igrača, dok će najveći volumen računalnih ciklusa dolaziti iz svakodnevnog korištenja AI sustava u proizvodima, poslovnim procesima i digitalnim uslugama. To tržište je veće, ali osjetljivije na cijenu. Kupci više neće tolerirati neučinkovite sisteme ako postoje jeftinije i energetski racionalnije alternative.

NVIDIA-in odgovor na taj pomak nije samo novi GPU, nego jačanje pozicije platforme. U narednom razdoblju ključna konkurentska prednost neće biti maksimalni broj operacija po sekundi, već sposobnost skaliranja na razini cijelog sustava. U praksi to znači integraciju procesora, memorije, međusobnog povezivanja, mreže i softvera u jednu cjelinu koju kupac može brzo implementirati i pouzdano koristiti. Takav pristup povećava trošak promjene dobavljača i daje NVIDIA-i dodatni prostor za zadržavanje marži čak i u okruženju jače konkurencije.

Istodobno, pojavljuju se realna ograničenja koja nisu tehnološka, nego fizička i ekonomska. Visokopropusna memorija postaje jedno od glavnih uskih grla, a dostupnost i cijena te memorije izravno utječu na cijenu i isporuku AI akceleratora. Paralelno s tim, potrošnja energije podatkovnih centara raste do razina koje postaju društveno, politički i financijski osjetljive. U mnogim regijama problem više nije nabava čipova, nego dostupnost električne energije, hlađenja i mrežne infrastrukture.

Na konkurentskoj strani, NVIDIA se suočava s pritiskom iz tri smjera. Veliki cloud pružatelji razvijaju vlastite čipove kako bi smanjili trošak inferencije i povećali kontrolu nad infrastrukturom. Ti čipovi nisu nužno bolji u apsolutnim performansama, ali su dovoljno dobri za specifične zadatke i znatno povoljniji kada se koriste u velikim količinama. Drugi izvor pritiska dolazi od konkurentskih proizvođača akceleratora koji postupno zatvaraju softverski i performansni jaz. Treći izvor su specijalizirani inference-first sustavi koji ciljaju niše u kojima je latencija važnija od fleksibilnosti.

Unatoč tome, NVIDIA zadržava snažnu poziciju zahvaljujući dubokoj integraciji hardvera i softvera te činjenici da velik dio industrije već funkcionira unutar njezina ekosustava. To ne znači da je njezina dominacija neupitna, nego da će se erozija tržišnog udjela, ako do nje dođe, događati postupno, a ne naglo.

Ključno pitanje za srednjoročni razvoj nije hoće li se umjetna inteligencija koristiti, nego hoće li tempo ulaganja u infrastrukturu ostati usklađen s tempom monetizacije. Postoji realan rizik da je dio podatkovnih centara izgrađen anticipirajući potražnju koja se još nije materijalizirala. Ako se prihodi od AI usluga ne budu razvijali dovoljno brzo, moglo bi doći do privremenog zastoja u kapitalnim ulaganjima, što bi se izravno odrazilo na narudžbe akceleratora.

U povoljnijem scenariju, tržište ulazi u fazu discipliniranog rasta. Ulaganja se nastavljaju, ali uz strožu kontrolu troškova i jasniji fokus na projekte s dokazivim povratom. U tom okruženju NVIDIA ostaje ključni dobavljač, iako uz postupno smanjenje premijskog položaja u dijelovima tržišta gdje cijena postaje dominantan faktor.

U nepovoljnijem scenariju, dolazi do šireg hlađenja investicijskog ciklusa. Projekti se odgađaju, financiranje se postrožuje, a tržište privremeno ulazi u fazu prekapacitiranosti. Takav razvoj događaja ne bi značio kraj umjetne inteligencije, ali bi značio naglu korekciju očekivanja i kratkoročni pritisak na sve infrastrukturne dobavljače, uključujući NVIDIA-u.

Najrealističniji ishod vjerojatno se nalazi između ta dva ekstrema. NVIDIA će u sljedećim godinama ostati temeljna infrastruktura AI ekosustava, ali u okruženju veće konkurencije, veće financijske discipline i sporijeg, ali održivijeg rasta. Dugoročna vrijednost tvrtke sve će manje ovisiti o samoj snazi pojedinog čipa, a sve više o sposobnosti da isporuči cjelovita, učinkovita i ekonomski opravdana AI rješenja.

Rizik pucanja AI balona!

Važno je razlikovati dva tipa “pucanja balona”;

Prvi je financijski: korekcija valuacija i očekivanja, dok se stvarna potražnja za AI infrastrukturom nastavlja. U tom scenariju NVIDIA bi mogla relativno dobro proći.

Drugi, ozbiljniji scenarij uključuje stvarno usporavanje ulaganja u podatkovne centre. Ako se pokaže da monetizacija AI usluga ne opravdava razinu investicija, doći će do rezanja kapitalnih izdataka, odgoda projekata i pritiska na dobavljače infrastrukture. NVIDIA je u tom slučaju ranjiva, ne zato što je tehnologija loša, nego zato što se nalazi u središtu investicijskog ciklusa.

Zaključak:

NVIDIA je u relativno kratkom povijesnom razdoblju postala jedan od ključnih stupova industrije umjetne inteligencije. Transformacijom iz proizvođača grafičkih kartica u infrastrukturnu kompaniju, uspjela je zauzeti središnje mjesto u razvoju i primjeni AI sistema. Ta pozicija proizlazi iz dugoročnog povezivanja hardvera, softvera i ekosistema u standard na kojem danas počiva velik dio AI industrije.

U kratkom roku, NVIDIA ostaje dominantan i teško zamjenjiv igrač. Inercija tržišta, pouzdanost rješenja i duboka integracija u postojeće sisteme osiguravaju joj stabilnu potražnju. Međutim, kako umjetna inteligencija ulazi u zreliju fazu, fokus se sve više prebacuje s tehnološke moći na ekonomsku opravdanost. Pitanja cijene, potrošnje energije i stvarnog povrata ulaganja postaju jednako važna kao i same performanse.

Najveći rizik za NVIDIA-u i cijelu AI industriju nije nestanak tehnologije, već mogućnost da se tempo ulaganja pokaže bržim od tempa monetizacije. U tom slučaju može doći do privremenog hlađenja investicija i korekcije očekivanja, često pogrešno opisane kao “pucanje balona”. Takav razvoj događaja ne bi značio kraj AI-ja, nego prijelaz u discipliniraniju i realističniju fazu rasta.

Dugoročno, NVIDIA-ina budućnost ovisit će o sposobnosti prilagodbe toj novoj fazi. Ako uspije zadržati ulogu standarda, uz veću učinkovitost i ekonomsku racionalnost, ostat će jedan od temeljnih nositelja digitalne infrastrukture. Ako ne, tržište će, kao i uvijek u tehnologiji, brzo nametnuti promjene.